Çinli bir şirkət 11 dəfə daha az emal gücü ilə süni intellekt modelini öyrədərək inqilabi uğur əldə edib!

Süni İntellekt

28.12.2024

Aslan Aslanov

Çinin süni intellekt sahəsində fəaliyyət göstərən startapı DeepSeek, sensasion bir açıqlama edərək, aparıcı süni intellekt şirkətlərinin modellərinə bənzər bir modeli 11 dəfə daha az hesablama gücü ilə hazırladıqlarını elan edib.

DeepSeek-in təqdim etdiyi məlumatlara görə, OpenAI, Meta və Anthropic kimi nəhənglərin modellərinə bənzər DeepSeek-V3 adlı dil modeli cəmi 2 ay ərzində 2.048 Nvidia H800 GPU-sundan ibarət bir qrup vasitəsilə 671 milyard parametr üzərində öyrədilib. Bu, təxminən 2.8 milyon GPU saatı deməkdir. Müqayisə üçün, Meta-nın 405 milyard parametrə malik Llama 3 modelini 54 gün ərzində 16.384 H100 GPU istifadə edərək öyrətməsi üçün 11 dəfə daha çox hesablama gücü (30.8 milyon GPU saatı) tələb olunub.

DeepSeek, qabaqcıl əlaqə xətti (pipeline) alqoritmləri, optimallaşdırılmış rabitə çərçivəsi və FP8 aşağı dəqiqlikli hesablama üsulundan istifadə edərək bu cür miqyaslı modellər üçün adətən tələb olunan hesablama və yaddaş ehtiyaclarını əhəmiyyətli dərəcədə azaltdığını iddia edir. Şirkət, DeepSeek-V3 modelinin hesablama tələblərini azaltmaq üçün onlarla optimizasiya texnikası tətbiq etdiyini vurğulasa da, bir neçə əsas texnologiya bu nəticələrin əldə olunmasında həlledici rol oynayıb. DeepSeek, DualPipe adlı alqoritmdən istifadə edərək həm hesablama, həm də rabitə mərhələlərində effektivliyi artırdığını bildirir. Bu alqoritm, xüsusilə MoE arxitekturasının tələb etdiyi qovşaqlararası ekspert paralelliyi üçün təlim darboğazlarını minimuma endirib. Beləliklə, sıfıra yaxın rabitə yükü ilə 14.8 trilyon simvolun işlənməsi mümkün olub.

Bundan əlavə, DeepSeek rabitə zamanı istifadə olunan qovşaqların sayını hər simvol üçün maksimum 4 qovşaqla məhdudlaşdırıb. Bu yanaşma trafiki azaldıb və rabitənin hesablama ilə effektiv şəkildə üst-üstə düşməsinə imkan verib. Performans baxımından, şirkət DeepSeek-V3 MoE modelinin bəzi göstəricilər üzrə GPT-4x, Claude-3.5-Sonnet və LLama-3.1 modelləri ilə müqayisə edilə bilən, bəzən isə onları ötüb, keçən nəticələr verdiyini bildirir. Lakin bu iddiaların müstəqil tədqiqatçılar tərəfindən təsdiqlənməsinə ehtiyac var. Şirkət modeli və onun parametrlərini açıq mənbə kimi təqdim edib, buna görə də yaxın vaxtlarda müqayisəli testlərin aparılması gözlənilir.

DeepSeek-V3 modeli parametrlərin sayı və ya məntiqi düşünmə qabiliyyətləri baxımından GPT-4 və ya Llama-3 kimi qabaqcıl modellərdən geri qalsa da, məhdud resurslarla yüksək səviyyəli bir MoE modelinin hazırlanmasının mümkün olduğunu nümayiş etdirir. Təbii ki, bu, çoxlu optimizasiya və aşağı səviyyəli proqramlaşdırma tələb edir, lakin nəticələr olduqca ümidverici görünür. DeepSeek komandası, DeepSeek-V3 modelinin tətbiqinin inkişaf etmiş avadanlıqla yanaşı, prefilling və dekodlaşdırma mərhələlərini bir-birindən ayıran xüsusi paylama strategiyası tələb etdiyini, bunun isə resurs çatışmazlığı səbəbindən kiçik şirkətlər üçün əlçatmaz ola biləcəyini etiraf edir.

Linki kopyala

Bənzər xəbərlər

Oxşar xəbərlər

Elon Musk: "2025-ci ilin sonuna kimi süni zəka istənilən insanın zəkasından daha güclü olacaq"

Elon Musk: "2025-ci ilin sonuna kimi süni zəka istənilən insanın zəkasından daha güclü olacaq"

Elon Musk müxtəlif mövzular barəsində proqnozlar verməyi sevməklə tanınır. Bu dəfə o, süni zəka sahəsi ilə bağlı növbəti proqnozunu verib.

Süni zəka ənənəvi antivirus tətbiqlərini qeyri-effektiv edib

Süni zəka ənənəvi antivirus tətbiqlərini qeyri-effektiv edib

Palo Alto Networks Unit 42 şirkətinin təhlükəsizlik üzrə mütəxəssisləri aşkar ediblər ki, böyük dil modelləri zərərli JavaScript kodunun demək olar sonsuz sayda müxtəlif versiyalarını tərtib edə bilirlər.

OpenAI məntiq yürüdə bilən o3 və o3 mini adlı yeni süni zəka modellərini təqdim edib

OpenAI məntiq yürüdə bilən o3 və o3 mini adlı yeni süni zəka modellərini təqdim edib

OpenAI şirkəti iki yeni süni zəka modelini təqdim edib. Onlardan birincisi o3, ikincisi isə o3 mini adlanır. Bu süni zəka modellərinin əsas fərqləndirici xüsusiyyətlərindən biri də odur ki, onlar məntiq yürütmək bacarığına sahibdirlər.

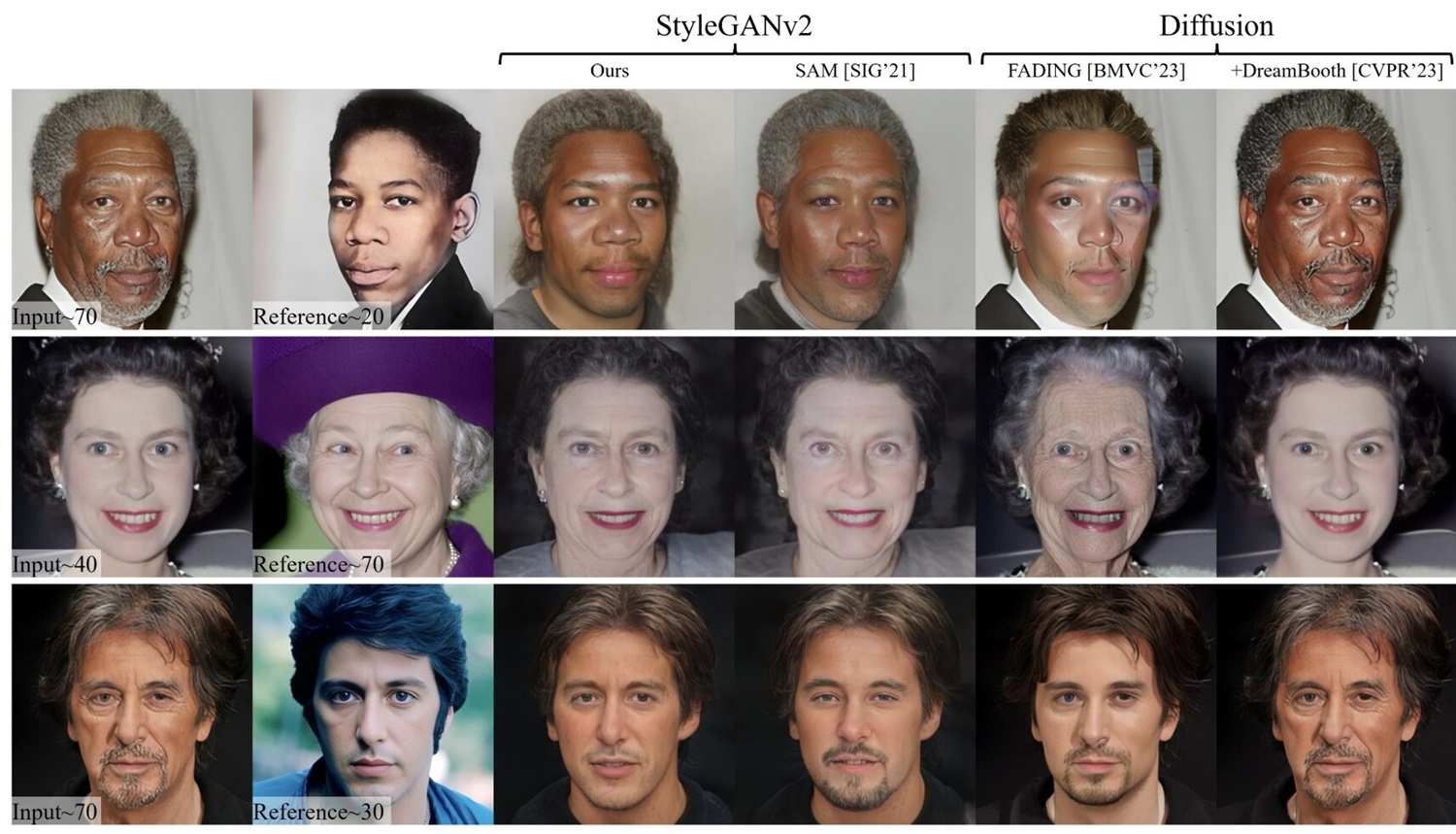

Videolarda insanları realistik şəkildə qocaldan və cavanlaşdıran süni zəka alqoritmi hazırlanıb (VİDEO)

Videolarda insanları realistik şəkildə qocaldan və cavanlaşdıran süni zəka alqoritmi hazırlanıb (VİDEO)

Şimali Karolina və Merilend Universitetlərinin mütəxəssisləri MyTimeMachine adlı süni zəka alqoritmini ərsəyə gətiriblər. Bu süni zəka alqoritmi videoda hər hansısa şəxsi realistik şəkildə qocalda və ya cavanlaşdıra bilər.

Süni intellekt 1.5 milyard illik təkamülün sirrini ortaya çıxarıb!

Süni intellekt 1.5 milyard illik təkamülün sirrini ortaya çıxarıb!

Çin Elmlər Akademiyasının Nankin Geologiya və Paleontologiya Elmi-Tədqiqat İnstitutunun rəhbərlik etdiyi beynəlxalq komanda süni zəka və böyük məlumat metodlarından istifadə edərək, kompleks həyatın 1.5 milyard illik təkamülünü yüksək dəqiqliklə ortaya çıxarıblar.

Həftənin xəbərləri